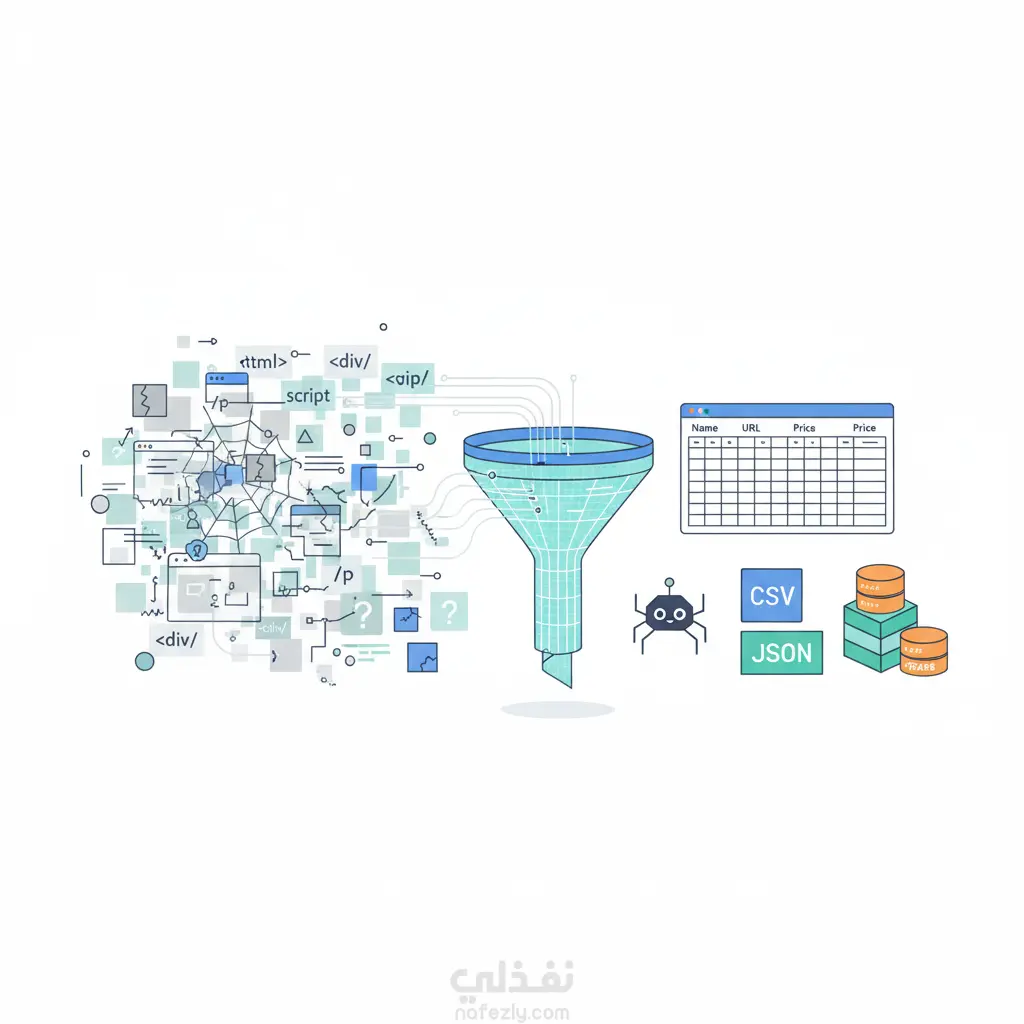

استخراج و تنظيف البيانات باستخدام الPython (Web Scraping)

تفاصيل العمل

نقدم حلولاً برمجية متخصصة لتحويل محتوى مواقع الويب إلى بيانات نظيفة، منظمة، وقابلة للاستخدام، مع الالتزام بالمعايير التقنية والأخلاقية. المخرجات والنتائج الرئيسية • استخراج بيانات منظّم: يشمل (الجداول، المنتجات، الأسعار، المقالات، إعلانات الوظائف، التقييمات، وغيرها). • صيغ تسليم متعددة: CSV, Excel, JSON, SQLite. • تكامل متقدم: إرسال مباشر للبيانات إلى قاعدة البيانات الخاصة بالعميل (Database) أو عبر واجهة برمجة تطبيقات (API). الإمكانيات التقنية معالجة المواقع الديناميكية (Dynamic Sites): o استخدام Selenium و Headless Chromium للتعامل مع الصفحات المعتمدة على JavaScript (SPA). كفاءة المواقع الثابتة (Static Sites): o استخدام Requests + BeautifulSoup لاستخراج سريع وفعال. تنظيف وتطبيع البيانات (Data Cleaning): o استخدام مكتبة pandas لإزالة التكرار، توحيد الأعمدة، معالجة القيم الشاذة، وإعداد مخطط بيانات (Schema) واضح. الأداء الواعي بالقيود: o تطبيق معدلات طلبات ذكية (Rate limiting). o استخدام التخزين المؤقت (Caching). o جدولة التشغيل الدوري (CRON / Windows Task). المراقبة والتوثيق رصد الأعطال (Error Handling): o نظام تسجيل (Logging) شامل. o لقطات شاشة آلية عند الفشل لتسهيل التشخيص. o إشعارات بسيطة (Email / Webhook). التوثيق الكامل (Documentation): o ملف README مفصّل. o مخطط تدفق للعمليات (Flowchart). o دليل تشغيل وصيانة. التسليمات النهائية • كود مصدر Python نظيف ومُعلّق. • ملف متطلبات التشغيل (requirements.txt). • ملف/قاعدة بيانات بالمخرجات النهائية (حسب الاتفاق). الباقات المقترحة • Starter: مصدر واحد، حتى 5 حقول، تشغيل يدوي، تسليم CSV/Excel. • Standard: حتى 3 مصادر، دعم صفحات ديناميكية، تنظيف متقدم، جدولة أسبوعية. • Pro: مصادر متعددة، Selenium، دفع مباشر لـ API/DB، مراقبة أساسية، دعم شهري. متطلبات البدء • روابط الصفحات المستهدفة. • أمثلة واضحة للحقول المطلوبة. • صيغة الإخراج المفضلة (CSV/Excel/JSON/DB). • تحديد تواتر التحديث المطلوب. • توضيح أي حدود قانونية أو تجارية يجب مراعاتها. • دليل تشغيل يتضمن تعليمات الجدولة وبنود القيود والافتراضات.

مهارات العمل

بطاقة العمل

طلب عمل مماثل