Big Data Spark

تفاصيل العمل

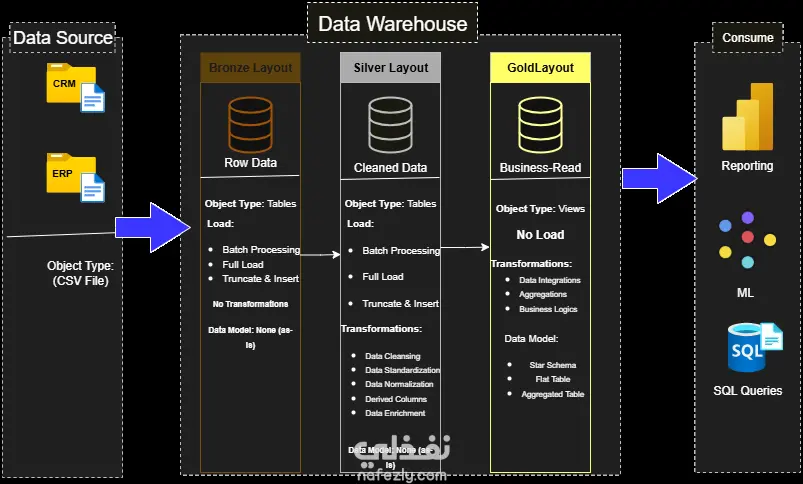

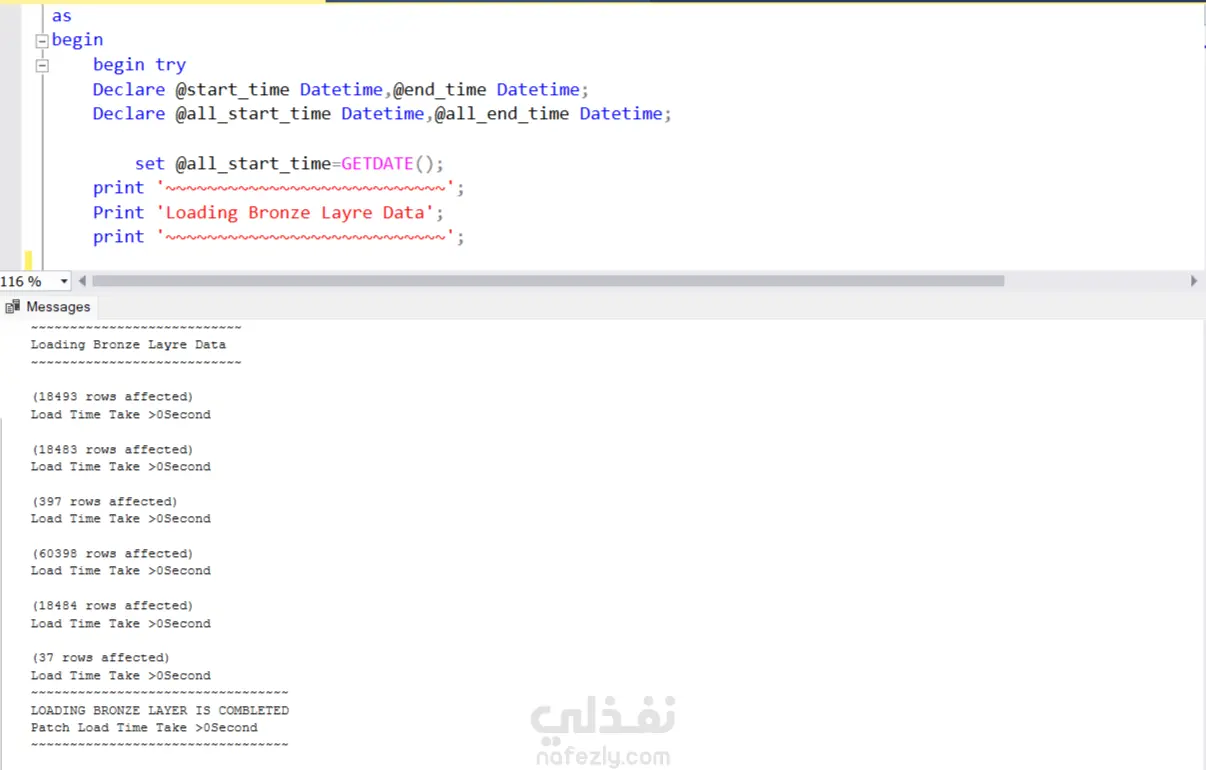

جمع البيانات (Data Ingestion): استيراد البيانات من مصادر مختلفة مثل قواعد البيانات، ملفات CSV/JSON/Parquet، أو أنظمة تخزين سحابية (مثل AWS S3 أو Azure Blob Storage). تنظيف وتحويل البيانات (Data Cleaning & Transformation): التعامل مع القيم المفقودة والمكررة. تحويل أنواع البيانات (Casting). إنشاء أعمدة جديدة باستخدام دوال PySpark. تطبيق عمليات التجميع (Aggregation) والتصفية (Filtering) والانضمام (Join). تحليل البيانات (Data Analysis): تنفيذ استعلامات مشابهة لـ SQL باستخدام واجهة pyspark.sql لتحليل البيانات على نطاق واسع.

مهارات العمل

بطاقة العمل

طلب عمل مماثل